机器人遵从伦理促进人机信任?决策类型反转效应与人机投射假说*

1前言,1阿西莫夫三大伦理原则,2机器人是否遵守伦理原则和机器人决策类型对人机信任的影响,3人机投射假说,4研究概述,2实验1:阿西莫夫第一伦理原则,1目的,2方法,3结果,4讨论,3实验2:阿西莫

王 晨 陈为聪 黄 亮 侯苏豫 王益文(1 福州大学经济与管理学院,福州 350116)

(2 闽南师范大学应用心理研究所,漳州 363000)(3 福建省应用认知与人格重点实验室,漳州 363000) (4 上海财经大学数字经济系,上海 200433)

1 前言

唯一的保障是制造出来的机器人总是严格地遵守第一原则——机器人在任何情况下都不能伤害人类。

——Asimov (1942)

随着人工智能(artificial intelligence,AI)技术的蓬勃发展,机器人作为人工智能的典型实例逐渐被应用到了生产、医疗、教育乃至军事等领域中,在促进人类福祉的同时也具有潜在的伦理风险。例如,机器人可能在人机交互中对人类造成身体或心理伤害(Maninger &Shank,2022),机器算法决策可能导致种族、年龄和性别歧视问题(Bigman &Gray,2018),抑或是机器生产、自动驾驶技术或将使数百万人失去工作(Etemad-Sajadi et al.,2022),甚至还可能出现工业、军事机器人导致人类伤亡的灾难(Johnson &Axinn,2013)。伦理风险影响人类对机器人的信任程度(Banks,2021),进而在很大程度上决定了人类是否使用机器人(Parasuraman &Riley,1997;Etemad-Sajadi et al.,2022)。因此,为了避免可能出现的伦理问题和人机信任危机,建立针对机器人的伦理体系一直是备受关注的议题。

1.1 阿西莫夫三大伦理原则

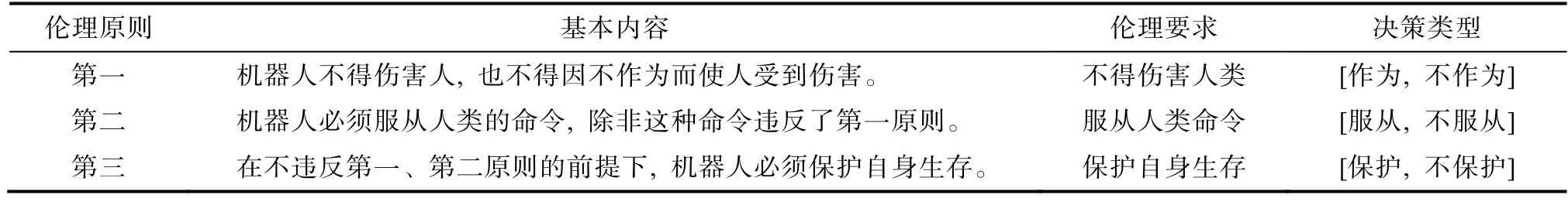

艾萨克·阿西莫夫(Isaac Asimov)在上世纪40年代就预见到需要伦理规则引导机器人的行为以防范伦理风险,并制定了最早的机器人伦理体系——机器人三大伦理原则(laws of robotics;Asimov,1942,详见表1)。

表1 阿西莫夫三大伦理原则

当前,随着机器人应用普遍性和自主决策能力的提高,可能催生各种难以预料的潜在后果,阻碍人与机器人之间信任关系的建立,这无疑不利于充分发挥人机互动的效益(Cameron et al.,2021)。对此,许多专家试图确定关键的伦理属性,并制定相应的伦理原则加以完善(Etemad-Sajadi et al.,2022) ......

您现在查看是摘要页,全文长 37081 字符。